【2025年10月06日訊】(記者陳俊村報導)可能有不少人認為,人工智能(AI)生成的說話聲聽起來很不自然,就像語音助理Siri或Alexa一樣。但英國的研究發現。AI技術已經發展到能讓其仿製的聲音酷似真人聲音,一般人難以分辨。這引發了人們對不肖分子利用AI仿製聲音從事詐騙等犯罪活動的擔憂。

英國倫敦瑪麗王后大學(Queen Mary University of London)在上個月發布的新聞稿中指出,該校心理學資深講師拉班(Nadine Lavan)表示,AI生成的聲音如今已遍布我們身邊。我們都曾與蘋果公司的Siri或亞馬遜公司的Alexa對話,或讓自動客服系統接聽電話。

拉班說:「這些聲音聽起來不太像真正的人聲,但AI技術開始產生自然、類似人類的語音只是時間問題。我們的研究表明,這個時刻已經到來,我們迫切需要了解人們如何看待這些逼真的聲音。」

由拉班主導的研究團隊將真人的聲音與兩種不同類型的合成聲音進行了比較,這兩種合成聲音均由最先進的AI語音合成工具產生。

其中一些合成聲音是從真人的錄音中「克隆」(複製)而來,其目的在模仿真人的聲音;另一些合成聲音則由一個大型語音模型生成,沒有模仿特定的人。

研究人員給參與者聽80種不同的聲音樣本(40種AI生成的聲音和40種真人的聲音),並要求他們標明哪些是真實的,哪些是AI生成的。

就平均而言,只有41%、由語音模型生成的AI聲音被誤認為是人類聲音。這表明在大多數情況下,人們仍然可以將它們與真人的聲音區分開來。

然而,從真人的錄音中仿製而來的AI聲音大多數(58%)被錯誤地歸類為人類聲音。只有62%的真人聲音被正確歸類為人類聲音。

研究人員因而得出結論說,人們在區分真人聲音和仿製的AI聲音的能力方面沒有統計上的差異。換言之,一般人難以分辨真人聲音和AI仿製的聲音。

拉班指出,其研究團隊輕鬆和迅速地使用市售軟體創造出真人(在獲得本人同意的情況下)的仿製或深度偽造(deepfake)聲音。

她說:「這個過程幾乎不需要專業知識,只需幾分鐘的錄音,而且幾乎不需要任何費用。這說明AI語音技術已經變得多麼普及和成熟。」

她提到,AI發展的速度非常快,已對倫理、版權和安全產生了許多影響,尤其是在虛假資訊、詐騙和冒充等方面。

如果犯罪分子使用AI來仿製你的聲音,那麼通過銀行的語音認證或欺騙你的親人轉帳就會變得更容易。

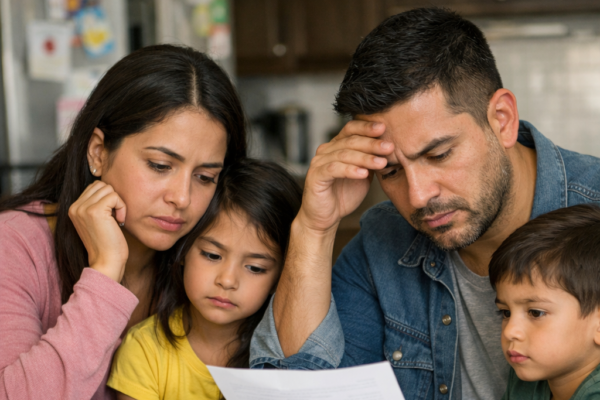

這樣的詐騙案件已經在世界各地發生過。舉例來說,美國佛羅里達州女子布萊特維爾(Sharon Brightwell)在今年7月就曾被AI仿製的聲音詐騙了1.5萬美元。

據WFLA電視台報導,布萊特維爾接到一通電話,電話號碼看起來像是她女兒的。一名女子在電話中哭著說,她遭遇了車禍,而她的聲音很像她女兒的聲音。

該名女子說,她開車時因為發簡訊而撞到一名孕婦,她的手機被警察沒收了。隨後,一名男子接過電話告訴布萊特維爾說,他是她女兒的律師。她的女兒被警方拘留了,需要1.5萬美元的保釋金。

布萊特維爾不疑有他,隨即依據對方提出的付款方式支付了1.5萬美元。她說:「沒人能說服我那不是她。我知道我女兒的哭聲。」

那些嫌犯後來又再度來電。他們聲稱該名孕婦的胎兒已經死亡。如果布萊特維爾不想讓女兒挨告,就必須支付3萬美元的賠償金。

但這一次,布萊特維爾的親友直接打電話給她女兒,不但證實了她女兒平安無事,也拆穿了那些嫌犯的謊言。

布萊特維爾的家人相信,嫌犯利用她女兒在臉書等社交媒體上的影片仿製了她女兒的聲音,進而對她進行詐騙。

布萊特維爾說:「我祈禱這種事不要發生在其他人身上。我先生和我剛退休,那筆錢是我們的積蓄。」

布萊特維爾敦促人們針對這種詐騙活動採取預防措施,例如使用暗號,以便在緊急情況下通過電話驗證身分。如果打電話來的人無法說出暗號,就直接掛電話。